Spróbujemy przybliżyć znaczenie konteneryzacji i orkiestracji kontenerów w praktykach DevOps przy użyciu Dockera i Kubernetesa. Czyli jak nowocześnie zarządzać aplikacją? Współpraca z narzędziami DevOps – systemami do ciągłej integracji (CI) i ciągłego wdrażania (CD) a skrótowo CI/CD. Opiszemy co to właściwie są kontenery, jakie są różnice między wirtualną maszyną a konteneryzacją - Dockerem, jaka jest rola Kubernetesa w tworzeniu i utrzymaniu aplikacji, zalety i wyzwania związane z wprowadzniem nowoczesnych metod współpracy progrmaistów oraz powstawania zautomatyzaowanego i zoptymalizowanego projektu programistycznego.

Współczesne podejście do wytwarzania, testowania i wdrażania oprogramowania wiąże się ściśle z koncepcją DevOps. DevOps to połączenie rozwoju (Development) i operacji (Operations), którego celem jest automatyzacja i optymalizacja cyklu życia aplikacji. W tym temacie kluczową rolę odgrywają właśnie konteneryzacja i orkiestracja kontenerów, umożliwiając szybkie, bardziej niezawodne i powtarzalne wdrożenia oprogramowania. Dokładnie opiszemy jak to się dzieje oraz wady i zalety w artykule poniżej. Zapraszamy do lektury i nauki!

Co to są kontenery w programowaniu i tworzeniu aplikacji? Do czego służą kontenery w środowiskach programistycznych?

Kontenery to lekkie, przenośne i izolowane środowiska uruchomieniowe, które zawierają aplikację oraz wszystkie jej zależności (biblioteki, pliki konfiguracyjne, itd.). Dzięki kontenerom aplikacja może działać identycznie w różnych środowiskach – od komputera programisty (twórcy kodu) po serwery produkcyjne, zarówno serwery chmurowe i fizyczne tradycyjne (stasjonarne, on-premise). Najpopularniejszym narzędziem do konteneryzacji, tworzenia kontenerów jest Docker.

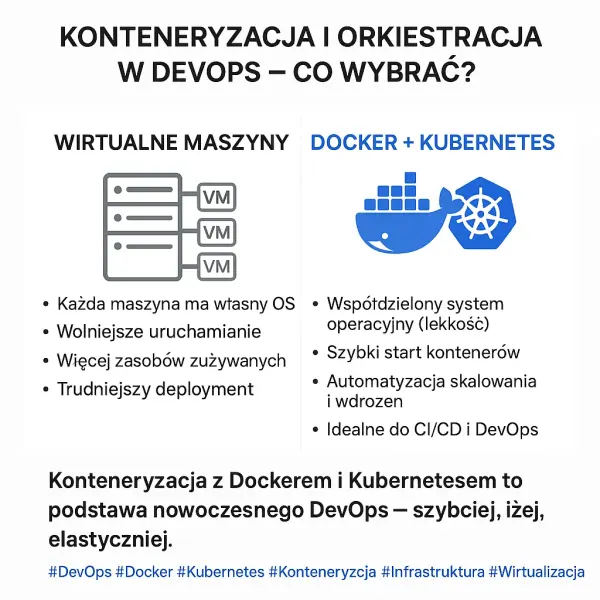

Cechy kontenerów, np Docker -owych w odniesieniu do wirtualnych maszyn:

Postaramy się przedstawić główne cechy kontenerów. Naszym zdaniem są to w większości zalety, niewiele wad. Pomogą zrozumieć cel wprowadzenia kontenerów do naszej aplikacji, dlaczego w ogóle stosujemy konteneryzacje w projekcie.

Kontenery umożliwiają szybkie uruchamianie i zatrzymywanie aplikacji.

– Ze względu na brak konieczności bootowania (rozruchu) całego systemu operacyjnego, kontenery dockerowe uruchamiają się w ciągu sekund, a nie minut. Kontenery pozwalają na szybkie skalowanie aplikacji oraz łatwe testowanie zmian. Taka szybkość jest szczególnie istotna w środowiskach DevOps, gdzie podczas zarządzania niezawodną aplikacją najważniejszy jest czas reakcji i wdrażania.

Niska narzutowość (lekkość kontenerów) w porównaniu do maszyn wirtualnych.

– Kontenery nie wymagają uruchamiania osobnego systemu operacyjnego (tak jak w wirtualnych maszynach, musimy mieć zainstalowanego np. Linuxa do uruchomienia), ponieważ współdzielą jądro systemu (kernel) z systemem gospodarza (hostem). Dzięki temu są znacznie lżejsze (mniej obciążają nasze urządzenia) niż maszyny wirtualne (VM) i zużywają mniej zasobów systemowych – zarówno pamięci RAM, jak i przestrzeni dyskowej. To wielka ulga dla programistów i ich sprzętów. Obrazy kontenerów mają często rozmiar liczony tylko w megabajtach, co ułatwia przesyłanie obrazów i ich przechowywanie.

Przenośność między różnymi systemami.

– Kontenery są niezależne od infrastruktury. Można je uruchamiać na dowolnej platformie, która obsługuje silnik kontenerów (np. Docker Engine), bez względu na to, czy jest to lokalna maszyna, serwer fizyczny, klaster, chmura publiczna, czy prywatna. Oznacza to, że aplikacja działa tak samo w każdym środowisku – praca wykonana „z mojego komputera” trafia na produkcję bez zmian.

Izolacja procesów w aplikacji dzięki konteneryzacji

– Każdy kontener działa jako oddzielny, odizolowany proces. Dzięki temu zmiany w jednym kontenerze nie wpływają bezpośrednio na inne. Możemy uruchamić wiele kontenerów na jednym hoście bez ryzyka konfliktów między aplikacjami lub ich zależnościami. Izolacja procesów w kontenerach zwiększa również bezpieczeństwo i stabilność środowiska programistycznego.

Konteneryzacja to spójność środowisk, wszystko w jednym miejscu

– Dzięki kontenerom całe środowisko uruchomieniowe aplikacji (kod źródłowy, zależności, biblioteki, konfiguracja) znajduje się w jednym obrazie. Eliminuje to błędy wynikające z różnic między środowiskami programisty, testera, a produkcją. Spójność środowisk to podstawa skutecznych i dobrych praktyk CI/CD.

Możliwość wersjonowania w Dockerze

– Obrazy kontenerów są wersjonowane – każdy obraz może mieć tag (np. v1.0, latest), co pozwala na łatwe zarządzanie cyklem życia aplikacji, szybkie cofnięcie zmian w przypadku błędów, a także tworzenie testowych wersji środowisk bez ryzyka wpływu na produkcję.

Skalowalność aplikacji dzięki zastosowaniu konteneryzacji

– Kontenery mogą być łatwo duplikowane (powielane) i rozmieszczane na różnych węzłach infrastruktury. Dzięki temu aplikacje można szybko skalować w poziomie (dodając więcej instancji), co pozwala obsłużyć większe obciążenie użytkowników.

Kontenery zapewniają łatwą integracje z DevOps

– Kontenery doskonale współpracują z narzędziami DevOps – systemami do ciągłej integracji (CI) i ciągłego wdrażania (CD). Pozwalają na automatyczne budowanie, testowanie i wdrażanie aplikacji w sposób powtarzalny i kontrolowany. Są też łatwe do monitorowania i zarządzania w zautomatyzowanym pipeline.

Kontenery a maszyny wirtualne (VM). Porównanie technologii i działania.

| Cecha | Kontenery (Docker) | Maszyny Wirtualne (VM) |

| Rozmiar | Lekkie (MB) | Cięższe (GB) |

| Czas uruchomienia | Sekundy | Minuty |

| System operacyjny | Współdzielony (kernel hosta) | Własny system OS |

| Izolacja | Procesowa | Pełna (systemowa) |

| Wydajność | Wyższa | Niższa (ze względu na hypervisor) |

Kontenery nie zawierają pełnego systemu operacyjnego, co sprawia, że są bardziej efektywne. Z drugiej strony, wirtualne maszyny oferują silniejszą izolację bezpieczeństwa.

Rola Kubernetesa w orkiestracji kontenerów

Kubernetes (K9s) to otwartoźródłowa (open-source) platforma do zarządzania, skalowania i orkiestracji kontenerów. Umożliwia automatyczne wdrażanie, monitorowanie, równoważenie obciążenia i naprawianie aplikacji w środowiskach kontenerowych.

Funkcje Kubernetesa:

– Orkiestracja kontenerów: zarządzanie cyklem życia kontenerów.

– Skalowanie: dynamiczne zwiększanie lub zmniejszanie liczby instancji.

– Self-healing: automatyczne restarty kontenerów w przypadku błędów.

– Load balancing: rozdzielanie ruchu między instancje aplikacji.

– Rolling updates: płynne aktualizacje bez przestojów.

Znaczenie konteneryzacji i Kubernetesa w DevOps

DevOps stawia na automatyzację, ciągłą integrację (CI) i ciągłe dostarczanie (CD). Kontenery i Kubernetes wspierają te cele w następujący sposób:

– Automatyzacja wdrożeń dzięki Kubernetes: Pipelines CI/CD mogą automatycznie budować i wdrażać obrazy kontenerowe.

– Konteneryzacja ułatwia testowanie: Testy uruchamiane są w identycznych środowiskach kontenerowych jak produkcja.

– Powtarzalność i standaryzacja w kontenerach: „Działa u mnie” to już nie problem – środowiska są standaryzowane.

– Skalowalność w Kubernetesie: Możliwość automatycznego dopasowywania zasobów do obciążenia.

– Niezawodność Kubernetesa: Kubernetes automatycznie zastępuje niedziałające instancje.

Zalety konteneryzacji i orkiestracji aplikacji

– Szybsze wdrażanie aplikacji.

– Lepsze zarządzanie zasobami.

– Łatwość w utrzymaniu i aktualizacjach.

Konteneryzacja znacząco upraszcza zarządzanie aplikacjami w środowiskach produkcyjnych:

Aktualizacja aplikacji sprowadza się do zbudowania nowej wersji obrazu i wdrożenia jej bez przerywania działania całego systemu (rolling update).

Stare wersje kontenerów mogą być błyskawicznie wycofane (rollback), co zwiększa bezpieczeństwo wdrożeń.

Standaryzacja kontenerów oznacza, że każda usługa jest utrzymywana tak samo – bez względu na technologię, język programowania czy środowisko.

– Mobilność między środowiskami (cloud/on-premise).

Kontenery działają w izolacji od systemu operacyjnego hosta, co oznacza, że raz zbudowany kontener można uruchomić praktycznie wszędzie – na komputerze programisty, w chmurze, czy na serwerze on-premise. Dzięki temu znika problem: „działa u mnie, ale nie na produkcji”.

– Ułatwienie testów automatycznych i CI/CD.

Łatwiejsze testowanie i debugging. Dzięki możliwości szybkiego tworzenia i usuwania kontenerów można łatwo replikować środowiska produkcyjne do celów testowych. To ułatwia testy regresyjne, integracyjne i szybkie debugowanie błędów.

– Skalowalność i elastyczność

Dzięki narzędziom orkiestracyjnym jak Kubernetes, można łatwo skalować aplikację w górę lub w dół w odpowiedzi na aktualne zapotrzebowanie. Skalowanie poziome (więcej instancji kontenera) jest zautomatyzowane i niemal natychmiastowe.

– Automatyzacja i samonaprawianie

Orkiestratory takie jak Kubernetes oferują funkcje samoleczenia – jeśli kontener przestanie działać, system automatycznie uruchomi nową instancję. Zmniejsza to ryzyko awarii i skraca czas reakcji na problemy.

– Ułatwienie wdrażania mikrousług

Konteneryzacja idealnie nadaje się do architektur opartych na mikrousługach, gdzie każda funkcjonalność aplikacji działa jako osobna usługa. Każda mikrousługa może być niezależnie rozwijana, testowana, wdrażana i skalowana.

– Integracja z narzędziami DevOps

Kontenery doskonale współpracują z nowoczesnymi narzędziami DevOps, takimi jak Jenkins, GitLab CI, ArgoCD czy Helm. Umożliwiają automatyzację całego procesu CI/CD, od builda po rollout.

– Wysoka dostępność, odporność na błędy i niezawodność

Orkiestracja umożliwia rozpraszanie kontenerów na różnych węzłach w klastrze, co zwiększa dostępność aplikacji. W przypadku awarii jednego węzła, ruch jest przekierowywany do innych, działających instancji.

Wyzwania i ograniczenia konteneryzacji - Dockera i zarządzania kontenerami - Kubernetesa

– Złożoność zarządzania w Kubenetesie: Kubernetes wymaga sporo wiedzy zanim zaczniemy z nim pracę.

– Bezpieczeństwo w Kubenetesie: Kontenery współdzielą jądro systemu hosta, co może prowadzić do ryzyk.

– Monitorowanie i logowanie w Kubenetesie: Wymaga specjalistycznych narzędzi (np. Prometheus, Grafana, ELK).

– Zarządzanie stanem w Kubenetesie: Aplikacje stanowe (np. bazy danych) są trudniejsze do konteneryzacji.

– Koszty operacyjne w Kubenetesie: Większe wymagania względem zespołu DevOps i infrastruktury.

Docker vs Kubernetes. Jakie są różnice i zastosowania?

Docker i Kubernetes to dwie często współwystępujące, ale pełniące zupełnie różne funkcje technologie. Poniżej tabela pokazująca różnice między Dockerem a Kubernetesem.

| Cecha | Docker | Kubernetes |

| Rodzaj narzędzia | Platforma do tworzenia i uruchamiania kontenerów | System do zarządzania (orkiestracji) kontenerami |

| Główna funkcja | Tworzenie, pakowanie i uruchamianie kontenerów | Automatyczne zarządzanie dużą liczbą kontenerów |

| Zakres działania | Pojedynczy kontener lub kontenery na jednej maszynie | Klaster wielu maszyn (węzłów) i setki kontenerów |

| Tworzenie obrazów | Tak (Dockerfile, docker build) | Nie, używa gotowych obrazów z repozytorium (np. Docker Hub) |

| Zarządzanie cyklem życia | Ręczne (docker run, docker stop) | Automatyczne (restarty, skalowanie, load balancing) |

| Skalowanie aplikacji | Ręczne, ograniczone do jednej maszyny | Automatyczne, dynamiczne w całym klastrze |

| Współdziałanie z innymi | Działa lokalnie, potrzebuje dodatkowych narzędzi do orkiestracji (np. Docker Compose, Swarm) | Samodzielna platforma orkiestracyjna z własnym API |

| Wdrożenia CI/CD | Obsługuje kontenery, ale nie zarządza ich wdrażaniem w środowiskach produkcyjnych | Umożliwia wdrażanie, aktualizacje i cofanie wersji |

Podsumowanie porównania: • Docker służy do tworzenia i uruchamiania pojedynczych kontenerów. • Kubernetes służy do zarządzania i orkiestracji kontenerów na wielu maszynach w dużej skali.

Można to porównać do relacji: Docker = budowa pojedynczego samochodu, Kubernetes = zarządzanie flotą samochodów, ich trasami i konserwacją.

W praktyce Docker i Kubernetes często są używane razem: • Docker tworzy kontenery i obrazy aplikacji. • Kubernetes zarządza ich rozmieszczeniem, dostępnością i skalowaniem w klastrze.

PRZYKŁADY tworzenia i uruchamiania środowiska Docker i Kubernetes

Prosty przykład z opisem i krótkim kodem dla Dockera i Kubernetesa

Przykład z Dockerem

Każda mikrousługa jest pakowana jako osobny kontener Dockerowy. Dzięki temu:

• Programista frontendowy tworzy swój kod w React, dołącza plik Dockerfile, buduje obraz frontend:latest i testuje go lokalnie.

• Zespół backendowy robi to samo z API w Node.js lub Java.

• Baza danych PostgreSQL uruchamiana jest jako gotowy kontener z Docker Hub (postgres:16), bez potrzeby osobnej instalacji.

Za pomocą pliku docker-compose.yml, deweloperzy mogą łatwo uruchomić cały zestaw usług lokalnie:

services:

frontend:

build: ./frontend

ports:

- "3000:3000"

backend:

build: ./backend

ports:

- "5000:5000"

db:

image: postgres:16

environment:

POSTGRES_PASSWORD: example

Zalety Dockera na etapie startu projektu: • Każdy członek zespołu uruchamia identyczne środowisko niezależnie od systemu. • Błyskawiczne testowanie interakcji między usługami. • Łatwe debugowanie i wymiana komponentów.

Przykład z Kubernetesem – produkcyjne wdrożenie i zarządzanie

Po przetestowaniu aplikacji kontenery trafiają do rejestru obrazów (np. Docker Hub lub GitLab Container Registry), a następnie są wdrażane w klastrze Kubernetes w chmurze (np. Google Kubernetes Engine, AWS EKS).

Co robi Kubernetes?

Uruchamia każdą usługę jako osobny pod (kontener lub zestaw kontenerów).

Umożliwia automatyczne skalowanie np. backendu, jeśli rośnie liczba użytkowników.

Zapewnia load balancing – równoważy ruch do wielu instancji frontendowych.

Monitoruje zdrowie usług – jeśli backend przestanie odpowiadać, uruchamia nowy kontener (self-healing).

Przechowuje dane konfiguracyjne w ConfigMaps i Secrets (np. dane dostępowe do bazy).

Przykład pliku YAML dla frontendu:

apiVersion: apps/v1

kind: Deployment

metadata:

name: frontend

spec:

replicas: 3

selector:

matchLabels:

app: frontend

template:

metadata:

labels:

app: frontend

spec:

containers:

- name: frontend

image: registry.example.com/frontend:latest

ports:

- containerPort: 3000

Zalety Kubernetesa na etapie wdrażania i zarządzania projektem na produkcji: • Aplikacja automatycznie skaluje się w godzinach szczytu (np. Black Friday). • Nowe wersje są wdrażane bez przestojów (rolling updates). • Monitoring i logowanie (np. Prometheus + Grafana, ELK Stack) zapewniają bieżący nadzór nad wydajnością. • Awaria jednej usługi nie blokuje działania całego sklepu.

Podsumowanie Konteneryzacji i orkiestracji na przykładzie Docker i Kubernetes wraz z porównaniem z wirtualną maszyną

Konteneryzacja i orkiestracja kontenerów to fundamenty współczesnych praktyk DevOps. Umożliwiają szybkie i bezpieczne wdrażanie aplikacji, automatyzację procesów oraz łatwe zarządzanie skalowalnością. Mimo pewnych wyzwań, ich korzyści są na tyle znaczące, że stanowią obecnie standard w rozwoju oprogramowania. Zobacz oficjalne strony z dokumentacją Kubernetesa i Dockera.

#pracaTestera #książka #elektronika

Przykłady:

Autor: Patrycja Mamrzeczy.pl